Egyenlőtlenségek és lehetőségek a nagy nyelvmodellek világában

A mesterséges intelligencia fejlődése válaszút előtt áll. Attól függően, hogy hogyan alakítjuk a jövőt, válhat belőle mindenki számára elérhető, vagy csak a globális nagyvállalatok által privilegizált eszköz is. Az MI demokratizálása nemes és hasznos cél ugyan, de a kapcsolódó fejlesztéseket jelenleg mégis jelentős globális egyenlőtlenségek jellemzik. A kérdés az, mi ezen egyenlőtlenségek gyökere, és mit tehetünk, hogy felszámoljuk azokat?

A mesterséges intelligencia, vagyis az olyan képességekkel rendelkező gépek, algoritmusok kutatása, amely képességeket korábban az ember sajátjaként kezeltünk, egyáltalán nem újkeletű. Visszatekintve a 20. századra láthatjuk, hogy egészen az 1950-es évektől kezdve kisebb-nagyobb figyelem övezte a témát. Már egészen korán kialakult néhány olyan irányzat, amelyek egészen napjainkig meghatározók, ilyen például a gépi fordítás is. A kezdeti lelkesedés után (a Gartner-görbének megfelelően) egyfajta kiábrándulás következett azonban a technológia alkalmazói és a megrendelők körében. Ez főként annak tudható be, hogy a kor megoldásai jóval költségesebbek voltak, mintha ugyanazt a munkamennyiséget emberekre bízták volna, teljesítményben azonban még messze elmaradtak az emberektől.

Ez a jelenség különösen látványos volt a már említett gépi fordítás esetében. A 60-as, 70-es években sorra láttak napvilágot olyan dokumentumok (főként az USA-ban), amelyek a mesterséges intelligencia kutatások kifizetődő jellegét kérdőjelezték meg. Ekkoriban a gépi fordítás (a hidegháború kontextusában) különösen fontos kutatási iránynak számított. Annak ígérete, hogy a szovjetektől szerzett szövegek rövid időn belül gyorsan, pontosan és automatikusan lesznek angolra fordíthatók, végül kivitelezhetetlennek bizonyult. A kor számítógépeinek fejlettsége és az alkalmazott algoritmusok (mai szemmel nézve) kiforratlansága gyakorlatilag kódolta az elvárások beteljesíthetetlenségét.

Érdekesség, hogy ekkoriban az automatikus fordítás kizárólag szabályalapon zajlott. Ez azt jelentette, hogy a számítógépeknek szótárak, nyelvtani és szemantikai szabályok figyelembevételével, gyakorlatilag alkotóelemiből kellett előállítani a lefordított szöveget. A megközelítés közel sem volt hibatűrő; ha például egy fordítandó mondat nem illeszkedett tökéletesen az előre kódolt szabályokba, a fordítás egyszerűen sikertelen volt. Nem elhanyagolható az a szempont sem, hogy a szabályokat egyesével kellett nyelvészeknek megalkotnia. Egy nyelv teljes leírása szabályalapon mindmáig nem teljesen megoldott kérdés, a folyamat munkaerő- és időigénye pedig elképesztő magasságokba szökött. Mindez természetesen a fejlesztési költségeken is megmutatkozott.

A problémákra előbb-utóbb a kutatásokat támogató vagy felügyelő hivatalos szervezetek is figyelmesek lettek. Az ALPAC (Automatic Language Processing Advisory Committee) 1966-os jelentése talán a leghíresebb az ekkoriban felerősödő kritikai hangok közül. A problémák, és a növekvő elégedetlenség hatására a gépi fordítás közel 20 éven keresztül érdemi finanszírozás, emiatt pedig érdemi fejlődés nélkül maradt. Mivel kezdetben ez jelentette a mesterséges intelligencia húzóágát, ez gyakorlatilag a teljes tudományterület háttérbeszorulását eredményezte.

Új lendületet az MI kutatás csak a 80-as években kapott, több tényezőnek köszönhetően. Ezek közül talán a legfontosabb a hardverek fejlődése volt. Az ekkor létező algoritmusok ugyanis „hagyományos” hardvert használtak a feladathoz szükséges számítások elvégzéséhez. Ez azt jelenti, hogy a modellek tanítása dominánsan a számítógépek processzorának (CPU) felhasználásával történt. Megjegyzendő, hogy ez egészen a 2010-es évek elejéig érdemben nem is változott.

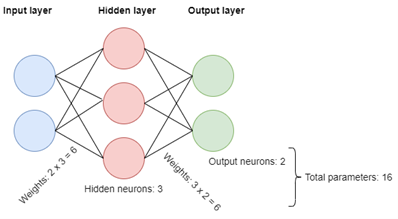

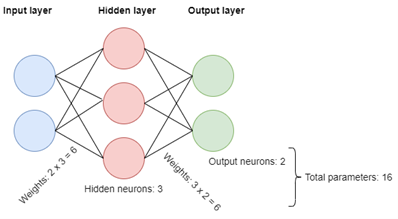

Az elmozdulást a neuronhálók, illetve a mélytanulás elterjedése hozta el. Ezek ugyanis a korábbitól gyökeresen eltérő elvek szerint működtek, amely a szükséges hardverek változását is maga után vonta. A gépi tanulásra, mint a modern mesterséges intelligencia kutatás domináns ágára jellemző algoritmusok hatékony működtetése gyakorlatilag kizárólag GPU-k segítségével lehetséges. Ez a gyakorlatban leginkább a létrejövő gépi tanult modellek előállításakor, a pre-training (vagyis a előtanítási) fázisban mutatkozik meg. [1]

Ahogyan már volt róla szó, a neuronhálókat mesterséges neuronok alkotják. Ezek rétegekbe szervezve helyezkednek el, köztük pedig kapcsolatok vannak definiálva. A kapcsolatok valós számokat tárolnak, ezeket nevezzük súlyoknak. A pre-training során a feladatunk valójában az, hogy ezen súlyokat, valamint az input rétegen kívül a többi neuronban tárolt értéket folyamatosan frissítsük. E két komponens együttesét nevezzük összefoglalóan paramétereknek. Ezt a frissítési folyamatot aztán egészen addig folytatjuk, amíg a háló bemenete és a kimenete közötti kapcsolat olyanná nem válik, ami megfelel az aktuális céljainknak.

A szerző ábrája

Modern mélytanuló hálók esetében egyszerre több százmillió, vagy akár milliárd paraméterről is beszélhetünk, amelyek értékeit akár több ezerszer is újra kell számolni. Ez olyanfajta számításigényt generál, amely CPU-val már kivitelezhetetlen, azonban a számítógépekben használt grafikus kártyák kiválóan alkalmasak rá.

Az pre-traininghez használt eszközöknek azonban mind a beszerzése, mind pedig az üzemeltetése rendkívül költséges. Hogy mennyire, azt jól illusztrálja az a becslés, mely szerint például a ChatGPT mögött eredetileg álló GPT-3-as nagy nyelvi modell (LLM) betanítása valahol 4 és 10 millió dollár közötti összegbe kerülhetett.

Ilyen szintű bekerülési költséget a legtöbb kis- és középvállalat nem engedhet meg magának. Ezen felül adódik még a probléma, hogy az ilyen modellek nem pusztán a pre-training során, de a későbbi használat (inference) során is igényelnek egyfajta hardveres architektúrát. Erre megoldást vagy saját eszközök beszerzése, vagy valamely népszerű felhő infrastruktúra szolgáltatónál történő bérlés jelenthet. Érdemes azonban fejben tartani, hogy az ilyen bérlés költségei is több ezer dolláros tételt jelenthetnek minden hónapban.

Mára kialakult tehát egy olyan helyzet, amikor ahhoz, hogy egy cég vagy kutatási projekt a legmodernebb megoldásokat alkalmazhassa, vagy elkészíthesse saját verzióját, a szükséges szakértelem mellett elsősorban rengeteg pénzre van szüksége. Ilyen mértékű befektetést azonban tipikusan csakis nagyvállalatok engedhetnek meg maguknak, akik aztán a befektetés megtérülését is elvárják. Mondhatjuk, hogy a legmodernebb megoldások fejlesztése és alkalmazása gyakorlatilag néhány technológiai óriásvállalat privilégiuma lett.

Ez a trend azonban ellentétes az átláthatóságot, elszámoltathatóságot és kiszámíthatóságot előtérbe helyező irányzattal, amelyet az MI demokratizálása néven ismerünk. Ennek keretében a fő cél, hogy például a mélytanuló megoldások fejlesztése során alkalmazott algoritmusok, a keletkezett modell és a tanításra használt adatok is bárki számára elérhetőek, nyilvánosak és elemezhetőek legyenek.

A helyzet tehát nem optimális, ugyanakkor fontos kiemelni, hogy az utóbbi időben történtek biztató fejlemények is a témában. A demokratizálás iránti növekvő igény például életre hív újfajta fejlesztési módszereket. Ezek azzal az ígérettel kecsegtetnek, hogy a hagyományos LLM-eknél (nagy nyelvi modellek) lényegesen kevesebb paraméterszámú vagy éppen hatékonyabban tanítható modellekkel érnek el a jelenlegi piacvezetőkhöz hasonló teljesítményt. Biztató az a trend is, hogy ma már számos olyan platform létezik, amelyeken a fejlesztéshez, modelltanításhoz használt kódok bárki számára ingyenesen megoszthatók (ilyen például a fejlesztők körében széleskörben használt GitHub). Emellett megemlítendő, hogy számos szolgáltató biztosít olyan felhő alapú számítási környezetet, amely alkalmas modellek betanítására, vagy éppen utólagos (feladat-specifikus) finomhangolására.

A mesterséges intelligenciával kapcsolatos fejlődés elképesztő ütemét, egyben a szükséges hardveres kapacitás egyre olcsóbbá válását jól szemlélteti, hogy például egy BERT modell finomhangolása ma már ingyenesen is megoldható felhő infrastruktúra használatával. Ilyen környezet mások mellett a Google Colaboratory is, ahol a fenti állítást ellenőriztük. A BERT-ről most elég annyit tudni, hogy ez volt az a modell, amely 2018-ban forradalmasította a neuronháló alapú megoldásokat. Egyben ezt tekinthetjük az első népszerű nagy nyelvi modellnek is.

A helyzet ilyen szempontból kettős, hiszen amennyiben az előtanított modell rendelkezésre áll, úgy azt bárki könnyen a saját igényei szerint finomhangolhatja, azonban az előtanítás még ezek esetében sem triviális feladat sem költségben, sem pedig szükséges szaktudás tekintetében. Fontos, hogy a jelenlegi trendek miatt sok esetben már egy néhány évvel korábbi technológia is elmarad teljesítményben a piacvezetőkhöz képest. Ez ahhoz is vezet, hogy versenyképesség szempontjából egyre szélesebbre nyílik az olló azok között, akik a megfelelő tőke birtokában lépést tudnak tartani a fejlődéssel és azok között, akik ezt nem engedhetik meg.

Jól látszik, hogy a fejlesztések többsége jelenleg az USA-ban koncentrálódik olyan nagyvállalatok fennhatósága alatt, mint a Meta, OpenAI, Microsoft, az Alphabet és egyéb Fortune500 vállalatok. Ezek mellett persze nem hanyagolható el Kína mesterséges intelligencia programja, vagy éppen az Európai Unió digitális szuverenitás elősegítésére irányuló programja sem. Ami a kutatási projekteket illeti, ezek esetében is hasonló egyenlőtlenség figyelhető meg. Míg a top egyetemek hozzáférhetnek a szükséges infrastruktúrához, addig kevéssé szerencsés társaik szinte teljesen kiszorulnak abból. Ez nemcsak a terület iránt érdeklődők elvándorlásához vezet, de egyben nagyban homogénné is teszi azt a közeget, ahol az ilyen irányú fejlesztések zajlanak[10]. Ez a homogenitás már középtávon is rontani fogja az eltérő gondolkodással rendelkező kutatók között az ötletek szabad áramlását, ami pedig végső soron az innovációs képesség drasztikus csökkenését vonhatja maga után.

Nem szabad elfelejtenünk azt sem, hogy egy adott technológia feletti kontroll minél kevesebb kézben összpontosul, annál inkább nő azok kiszolgáltatottsága, akik közvetlenül nem képesek ahhoz hozzáférni.

Habár a mélytanuláson alapuló megoldások korunk egyik meghatározó kutatási és ipari fejlesztési irányává váltak, a technológia nyújtotta előnyök kihasználása közel sem biztosított mindenki számára egyenlő mértékben. Főként az ilyen irányú fejlesztések rendkívül magas bekerülési költsége miatt a legmodernebb módszerek alkalmazása ma mindössze néhány szereplő kiváltsága. Ez egyaránt érvényes az ipar és a kutatás területén is. A megoldást olyan (akár nemzeti szintű) infrastruktúra kiépítése jelentheti, amely egyaránt hozzáférést biztosít a szükséges erőforrásokhoz mindenki számára. Ez lehetőséget adhat a jelenleginél szabadabb kísérletezésre, a már létező megoldások jobb megértésére, valamint a jövő mesterséges intelligencia alapú módszereinek átláthatóbb fejlesztésére is.

A cikk szerzője Üveges István, a MONTANA Tudásmenedzsment Kft. számítógépes nyelvészeti szakértője, valamint a HUN-REN Társadalomtudományi Kutatóközpont projektkutatója.

A cikk angolul Inequalities and Opportunities in the World of Large Language Models címmel a Constitutional Discourse oldalán jelent meg.

[1] A jelen írás terjedelmét messze meghaladná a magyarázat részletes ismertetése. Ugyanakkor a dolog háttere abban keresendő, hogy a grafikus kártyák (amelyeket eredetileg 3D grafikákhoz fejlesztettek ki) rendkívül hatékonyak mátrix-műveletek elvégzésében. Ez főleg a hatékony párhuzamosításnak köszönhető. Ez a képességük pedig pont kapóra jön, amikor neuronhálók paramétereit kell újra számolni.